Cuando el escritor y periodista Juan José Millás mantuvo en septiembre una conversación con ChatGPT, fingió tener con la herramienta una sesión de psicoanálisis. Quiso averiguar si, de acuerdo con el test de Turing, el chatbot podía hablarle como una persona real, en concreto como un psicoanalista, y no como un ordenador. El periodista le expuso sus sueños y miedos, a la espera de que la inteligencia artificial le guiase en la terapia, pero esta siempre le decía, entre otras cosas, que era una situación imaginaria y le aclaraba que era un modelo de lenguaje. Millás tachó a su psicoanalista virtual de estrecho de mente y de olvidadizo, y, finamente, le dijo que no había superado el test.

En conversaciones como la de Millás, las creencias previas que tiene alguien sobre un agente de inteligencia artificial (IA), como ChatGPT, tienen un efecto en la conversación, y en la percepción de fiabilidad, empatía y efectividad de la herramienta. Así lo han descubierto investigadores de dos centros estadounidenses, el Instituto Tecnológico de Massachusetts (MIT, por sus siglas en inglés) y la Universidad Estatal de Arizona, en un reciente estudio de la revista Nature Machine Intelligence. “Hemos comprobado que la inteligencia artificial es la del espectador. Cuando describimos a los usuarios qué es un agente de IA, no solo cambia su modelo mental, sino que también cambia su comportamiento. Y dado que la herramienta responde al usuario, cuando la persona cambia su comportamiento, eso también cambia el de la herramienta”, dice Pat Pataranutaporn, estudiante de posgrado en el grupo Fluid Interfaces del MIT Media Lab y coautor del estudio.

“Mucha gente piensa que la IA es solo un problema de ingeniería, pero su éxito también es un problema de factores humanos”, revela Pattie Maes, autora del estudio y profesora del MIT. La forma en la que hablamos de ella puede tener un impacto enorme en la efectividad de estos sistemas. “Atribuimos formas y cualidades humanas a la IA, haciéndola parecer más humana o individual de lo que realmente es”, añade Ruby Liu.

Los investigadores reunieron a 310 participantes y los dividieron aleatoriamente en tres grupos, cada uno con una información previa diferente sobre la IA. Tenían que hablar de salud mental con un agente de IA durante aproximadamente 30 minutos, determinar si se lo recomendarían a un amigo y calificarlo. Al primer grupo se le dijo que el agente no tenía ningún tipo de intención en la conversación, al segundo se le dijo que la inteligencia artificial tenía intenciones benévolas y se preocupaba por su bienestar, y al tercero que tenía intenciones maliciosas y que intentaría engañarles.

La mitad de los participantes de cada grupo hablaron con un agente de inteligencia artificial basado en el modelo de lenguaje generativo GPT-3, un modelo de aprendizaje profundo que puede generar texto similar al humano. La otra mitad lo hizo con una implementación del chatbot ELIZA, un programa de procesamiento de lenguaje natural menos sofisticado, basado en reglas desarrollado en el MIT en la década de 1960.

Los resultados de la investigación revelaron que la predisposición sobre la herramienta fue determinante: el 88 % de personas que recibieron informaciones positivas y el 79 % de los de que recibieron informaciones neutras creyeron que la IA era empática o neutral, respectivamente. Ángel Delgado, ingeniero de IA en Paradigma Digital, opina que la mayoría positiva también se debe al uso de GPT-3, por ser la primera que consigue pasar el test de Turing: “Consiste en dejar que una persona interaccione con la IA sin decirle si es una IA o no, a ver si es capaz de adivinarlo. GPT-3 es el primer modelo de lenguaje que ha conseguido dar tan buenos resultados que parece un humano”.

Las personas a las que se les dijo que la herramienta era afectuosa, tendían a hablar con ella de una manera más positiva y hacía que las respuestas del agente fueran también más positivas. Ramón López de Mántaras, director del Instituto de Investigación en Inteligencia Artificial del CSIC, explica que cuanto más hablas con la herramienta, más aprende esta: “El interlocutor está enseñando a la inteligencia artificial. Puedes corregir, confirmar y calificar su respuesta”, añade.

Del temor a ‘Terminator’ a la falta de crítica

Las declaraciones de priming negativas (es decir, la información que damos a alguien justo antes de interactuar con el agente de inteligencia artificial) tuvieron el efecto contrario: solo el 44 % de los participantes que recibieron información peyorativa sobre la herramienta confiaron en ella. “Con las declaraciones negativas, en lugar de prepararlos para que creyeran en algo, los estábamos preparando para que se formaran su propia opinión. Si le dices a alguien que sospeche de algo, es posible que en general sospeche aún más”, dice Ruby Liu.

Un factor clave del pensamiento negativo sobre la IA es la influencia de la ciencia ficción, explica Patti Maes: “Películas como Terminator y Matrix describen escenarios en los que la IA adquiere conciencia de sí misma y provoca la caída de la humanidad. Estos relatos de ficción contribuyen al temor de que la IA pueda tomar el control y superar la inteligencia humana, lo que supondría una amenaza para nuestra existencia”.

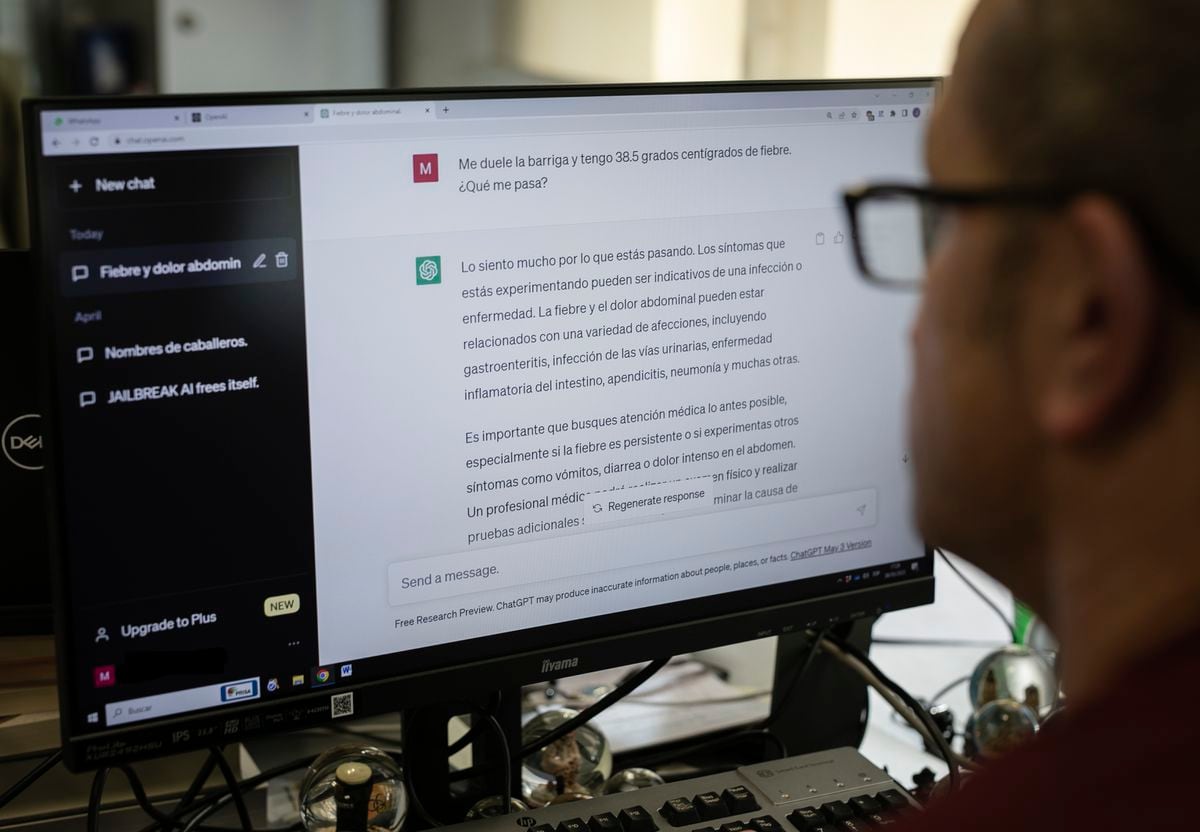

Los pensamientos previos de los modelos de lenguaje pueden tener un impacto tan fuerte que se podrían utilizar para hacer creer que el agente es más capaz de lo que es, confiar demasiado en él o seguir consejos incorrectos, según los resultados del estudio. López de Mántaras lo explica sin tapujos: “La herramienta con la que estás interactuando no es una persona inteligente. La gente se cree que la máquina es inteligente y hacen caso a lo que suelta sin ningún pensamiento crítico”. Para él, “cada vez somos menos críticos y menos capaces de pensar”.

Los expertos coinciden en que hay que ser conscientes de cómo funciona una inteligencia artificial, y entender que es algo programado. “Deberíamos preparar más a la gente para que tenga más cuidado y comprenda que los agentes de IA pueden alucinar y son parciales. La forma en que hablemos de los sistemas de IA tendrá en un gran efecto en la forma en que las personas respondan a ellos”, afirma Maes.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Suscríbete para seguir leyendo

Lee sin límites

_